Ratgeber

Leistungsstarke NVIDIA Grafikkarten für Gaming und Multimedia

Mit einer leistungsstarken Grafikkarte lässt sich aus vielen Rechnern deutlich mehr herausholen, auch wenn es sich nicht mehr um das neueste Modell handelt. Mithilfe von Grafikkarten mit einem Chipsatz von NVIDIA lassen sich Filme und Spiele auch in Full-HD-Auflösung ruckelfrei genießen.

NVIDIA ist in erster Linie ein Hersteller von Chipsätzen und Grafikprozessoren für PCs und Spielekonsolen. Neben AMD ist das US-amerikanische Unternehmen mit seiner Marke GeForce einer von zwei dominierenden Anbietern im genannten Sektor. Die meisten der auf dem Markt erhältlichen Grafikkarten verfügen über einen GeForce-Grafikprozessor von NVIDIA, zum Beispiel die Gaming-Grafikkarte NVIDIA GeForce GTX1060 Gaming X6 von MSI oder die ROG Strix GeForce GTX 1070 von Asus.

Neben Grafikkarten von Drittanbietern vertreibt NVIDIA auch eigene Module mit den Prozessoren. Das Sortiment deckt alle Leistungs- und Preisklassen ab. Es reicht von günstigen Lösungen für genügsame Komplett-PCs, zum Beispiel die ältere GeForce GTX 1050, bis zu High-End-Grafikkarten wie der NVIDIA QUADRO RTX 6000 für Design und andere anspruchsvolle Anwendungen im Bereich Visualisierung.

Grafikkarten sind Hardware-Komponenten für PCs, die zur Berechnung von Grafikdaten zuständig sind. Indem sie die Aufbereitung von Rohdaten zu Bildern und die anschließende Ausgabe übernehmen, entlasten sie die Central Processing Unit (englisch: „zentrale Recheneinheit”) oder CPU des Computers. Diese kann sich, vereinfacht ausgedrückt, auf für das System wichtigere Aufgaben konzentrieren, wodurch der Rechner insgesamt mehr leisten kann. Grafikkarten dienen also im weiteren Sinne der Hardwarebeschleunigung.

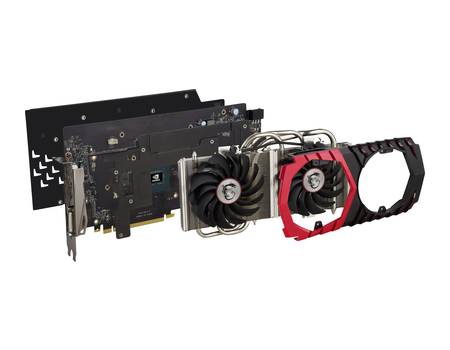

Grafikkarten sind ihrer Funktion entsprechend spezialisiert. Auf den Karten, die je nach Bauart entweder direkt auf das Mainboard eines Computers aufgesteckt oder durch andere Schnittstellen wie HDMI und USB-C damit verbunden werden, befinden sich in der Regel drei wesentliche Komponenten. Die sogenannte Graphics Processing Unit (GPU) ist das grafische Äquivalent zur CPU und Herzstück einer jeden Grafikkarte. Die GPU dient als Prozessor, berechnet also alle Daten, für die die Grafikkarte zuständig ist. GPUs sind durch ihren Aufbau besonders für den Umgang mit Grafikdaten geeignet. Solche Daten sind vergleichbar einfache Aufgaben für Recheneinheiten, werden durch visuell aufwendige Programme wie hochauflösende PC-Spiele oder Videos in Full-HD aber massenhaft gestellt. Im Vergleich zu CPUs von ähnlicher Qualität weisen GPUs deshalb eine geringere Taktfrequenz, aber mehr Prozessorkerne auf.

Um die berechneten Daten und ausgeführten Programme zwischenspeichern zu können, ist ein Arbeitsspeicher oder RAM (Random Access Memory) auf Grafikkarten vorhanden, auch Grafikspeicher genannt. Die durch die GPU verarbeiteten digitalen Daten werden anschließend über Schnittstellen an einen oder mehrere Monitore ausgegeben. Je nach Modell sind Grafikkarten mit einer unterschiedlichen Kombination von Schnittstellen ausgestattet. Die gängigsten Typen sind HDMI (High Definition Multimedia Interface) und DisplayPort. Ältere Geräte lassen sich über DVI (Digital Visual Interface) oder VGA (Video Graphics Array) anschließen. Da VGA ein analoges Verfahren ist, müssen die digitalen Daten einer Grafikkarte in analoge Bildsignale umgewandelt werden, um von einem entsprechenden Monitor angezeigt werden zu können. Dazu dient bei Karten mit VGA-Anschluss ein von der GPU gesondert verbauter Chip, der Random Access Memory Digital/Analog Converter (RAMDAC).

Grafikkarten mit NVIDIA-Chipsatz gibt es für unterschiedliche Anwendungsfelder. Je nach Einsatzzweck können Leistung, Spezifikationen, Design und Preis stark variieren. Zum einen bietet NVIDIA Chipsätze für enorm leistungsstarke Workstation Grafikkarten an. Modelle wie die Quadro RTX 8000 sind für professionelle Anwendungen in Komplett-PCs oder speziellen, industriellen Rechnern vorgesehen, zum Beispiel zur Nutzung von sogenannten CAD-Programmen. „CAD” steht für computer-aided design (englisch für „computerunterstütztes Gestalten”) und beschreibt die digitale Modellierung und Konstruktion eines Produktes, zum Beispiel eines Fahrzeuges oder eines Maschinenbauteils. Solche Programme sind grafisch besonders anspruchsvoll. Außerdem ist es oft erforderlich, weit mehr Bildschirme für solche Prozesse an eine Grafikkarte anzuschließen als bei der privaten Nutzung.

Der größere Teil des Sortiments von NVIDIA sind für den privaten Gebrauch als Hardwarebeschleunigung für Multimedia- oder Gaming-PCs vorgesehen. Sie werden unter der Marke GeForce geführt. GeForce Grafikkarten werden ständig weiterentwickelt. Je nachdem, wie aktuell ihre Prozessorarchitektur und die durch ein Modell unterstützten Technologien sind, weisen sie große Preis- und Leistungsunterschiede auf. Das aktuelle Flaggschiff von GeForce ist die RTX 2080 Super. Sie ist mit der neuesten Turing-Prozessorarchitektur ausgestattet, die Echtzeit-Raytracing unterstützt. Dabei handelt es sich um einen Algorithmus zur besseren Verdeckungsberechnung, die ermittelt, ob und in welchem Maß dreidimensional animierte Objekte innerhalb eines Bildes sichtbar sind. Raytracing ermöglicht somit eine noch höhere Bildqualität.

Zentrales Bauteil einer jeden Grafikkarte ist ihr Prozessor. Dementsprechend wichtig sind die Eigenschaften der jeweiligen Graphics Processing Unit für die Auswahl des richtigen Modells. Auf den ersten Blick lässt sich durch zwei Indikatoren einschätzen, wie leistungsstark ein Prozessor ist. Insbesondere für Grafikprozessoren spielt die Zahl der Kerne eine große Rolle. Je mehr Kerne vorhanden sind, desto besser lassen sich die massenhaften Rechenaufgaben durch grafisch anspruchsvolle Anwendungen verteilen. Die Spanne reicht bei NVIDIA-Grafikprozessoren von relativ geringen Kernzahlen wie den 640 Cores der GeForce GTX 1050 über die in der GeForce GTX 1660 Ti verbauten 1536 Cores bis hin zu den 4352 Cores der GeForce RTX 2080 Ti.

Im Falle von Prozessoren speziell für Grafikkarten wirkt sich die Kernzahl zudem wesentlich auf den anderen ausschlaggebenden Indikator aus, die Taktrate beziehungsweise den Boost-Takt. Die Prozessortaktrate, gemessen in Megahertz (MHz) gibt Aufschluss darüber, wie viele Berechnungen ein Prozessor innerhalb einer Sekunde durchführen kann. Einfach formuliert: Je höher die Taktrate in MHz, desto schneller ist die GPU. Dabei handelt es sich aber mehr um eine Faustregel als um ein eisernes Gesetz. Vor allem bezüglich Grafikprozessoren beziehungsweise -karten können leistungsstärkere Modelle durchaus geringere Taktraten aufweisen als bescheidenere Ausführungen. Die GeForce GTX 1660 Ti taktet ohne Boost zum Beispiel mit 1500 MHz, während die wesentlich leistungsfähigere und teurere GeForce RTX 2080 Ti nur zu einem Takt von 1350 MHz imstande ist.

Ein wesentliches Hindernis für höhere Taktraten ist Wärmeentwicklung. Je intensiver die GPU belastet wird, desto mehr heizt sie sich auf. Um nicht zu überhitzen, ist bei einer bestimmten Taktrate Schluss. Allerdings verfügen einige moderne Mehrkernprozessoren über einen speziellen Trick, um bei gleicher Wärmeentwicklung mehr Leistung zu erzeugen. Sie „übertakten”. Ältere Programme können nur auf einen Kern zugreifen, während andere gegebenenfalls vorhandene Kerne in einen Energiesparmodus übergehen. Dabei bleibt die Temperatur weit unter dem Maximum, selbst wenn der beanspruchte Kern bei maximaler Rate taktet. In diesem Fall sind manche Grafikkarten in der Lage, die Taktrate des beanspruchten Kerns deutlich über den maximalen Basistakt auf einen Boost-Takt zu erhöhen. So kann die GeForce GTX 1660 Ti übergangsweise mit 1770 MHz statt mit 1500 MHz und die GeForce RTX 2080 Ti mit 1545 MHz statt 1350 MHz takten.

Neben der GPU weisen die anderen Komponenten je nach vorgesehener Anwendung und Preisklasse der Grafikkarte ebenfalls wesentliche Leistungsunterschiede auf. Die Kapazität eines Grafikspeichers in Gigabyte (GB) entscheidet über die Menge der Daten, die er zu jedem Zeitpunkt zwischenspeichern kann. Ein großer Speicher ist aber nur dann nützlich, wenn er die gespeicherten Daten auch schnell übertragen kann. Deshalb ist die sogenannte Speicherbandbreite in Gigabyte pro Sekunde (GB/s) zu beachten. Außerdem sollte eine Grafikkarte über ausreichend Schnittstellen verfügen. Ist die Grafikkarte für einen Komplett-PC im Büro vorgesehen, reichen im Grunde ein bis zwei Anschlüsse für Bildschirme. Gamer und CAD-Profis sollten sich hingegen die Möglichkeit offenhalten, mindesten drei hochauflösende Monitore über HDMI oder DisplayPort anschließen zu können.

Ein unerwünschter Effekt, der bei der Ausgabe von Videos beziehungsweise dynamischer Spielgrafik häufig auftreten kann, ist das sogenannte „Tearing”. Während Monitore normalerweise eine feste Bildwiederholrate besitzen, variiert die Bildausgabe durch Grafikkarten je nach Leistungsfähigkeit des Computers und momentaner Belastung. Ist der Bildaufbau durch einen Prozessor nicht mit der Wiedergabe durch den angeschlossenen Monitor synchron, werden Fragmente mehrerer Einzelbilder gleichzeitig anzeigt – das Bild wirkt zerrissen. Selbst bei hochauflösenden Bildschirmen aus dem High-End-Bereich kann Tearing auftreten; angesichts der Preise für solche Modelle besonders ärgerlich.

Eine gängige Technologie, um Tearing zu verhindern, ist das sogenannte „V-Sync”. Durch V-Sync passt sich die Grafikkarte bei der Ausgabe der Bilder der Wiederholrate des Bildschirms an. Optimal ist die Lösung aber nicht, da sich eine leistungsstarke Grafikkarte gegebenenfalls der schlechten Leistung eines Bildschirms anpassen muss und Bilder berechnet, die nicht angezeigt werden. NVIDIA hat V-Sync für seine GeForce Grafikkarten deshalb weiterentwickelt. „G-Sync” ermöglicht eine adaptive Bildwiederholrate für Bildschirme, wodurch Ausgabe und Anzeige jederzeit aufeinander abgestimmt sind. Um G-Sync zu verwenden, muss ein Monitor allerdings mit einem entsprechenden Modul ausgerüstet sein.

Sind NVIDIA-Grafikkarten besser oder schlechter als Modelle von AMD?

Ob NVIDIA bessere Grafikkarten anbietet als AMD oder andersherum lässt sich nicht pauschal sagen. Der Markt bietet zu viele Grafikkarten der beiden Hersteller in unterschiedlichen Varianten und in Kombination mit unterschiedlichen Komponenten von Drittanbietern. Außerdem erscheinen regelmäßig neue Modelle. Selbst bei Grafikkarten mit identischen Spezifikationen kann es je nach Anwendung zu Leistungsunterschieden kommen, weil einzelne Programme mit unterschiedlichen Technologien kompatibel sind, die nicht von allen Grafikkarten unterstützt werden. Auch das Zusammenspiel mit anderen PC-Komponenten spielt eine Rolle. Unter vielen Fachleuten gilt jedoch die rein anekdotisch belegte Annahme, dass NVIDIA bei den absoluten High-End-Modellen die Nase vorn hat.

Macht es einen Unterschied, eine NVIDIA-Grafikkarte über HDMI oder über DisplayPort an einen Monitor anzuschließen?

HDMI und DisplayPort sind beide digitale Schnittstellenstandards, die bereits vor einiger Zeit entwickelt wurden. Seitdem sind immer wieder neuere Versionen beider Verfahren erschienen, durch die höhere Übertragungsraten möglich sind. Es ist also schwer zu sagen, ob sich die Leistung einer Grafikkarte durch DisplayPort oder HDMI optimieren lässt. Zumal es vom Auge der Betrachtenden abhängt, was ein „besseres” Bild ausmacht. Allgemein gilt, dass DisplayPort über höhere Übertragungsraten und maximale Auflösungen verfügt, während sich HDMI-Schnittstellen durch eine höhere Farbtiefe auszeichnen, was aussagt, wie viele Abstufungen von Helligkeits- und Farbwerten sie übertragen kann. Die aktuellste Version von DisplayPort, DisplayPort 2.0, wurde im Juni 2019 veröffentlicht. Sie ermöglicht eine maximale Übertragungsrate von 80 GBit/s und eine Farbtiefe von 30 Bit pro Pixel. Der neueste HDMI-Standard, HDMI 2.1, überträgt Daten zwar nur mit 38,4 GBit/s. Er bietet aber Farben einer Tiefe von 48 Bit pro Pixel.